TechCrunch 分钟:关于 OpenAI 的新 GPT-4o 模型你需要知道的一切

推荐使用国际直连GPT,立即访问: www.chatgp1.com

如果你一直在关注 OpenAI 的新闻,那么你可能已经看到有报道称该公司正在开发一款搜索产品,该产品原定于本周发布。这并没有发生,但它透露了一些可能更令人印象深刻的东西——它推出了最新模型 GPT-4o。

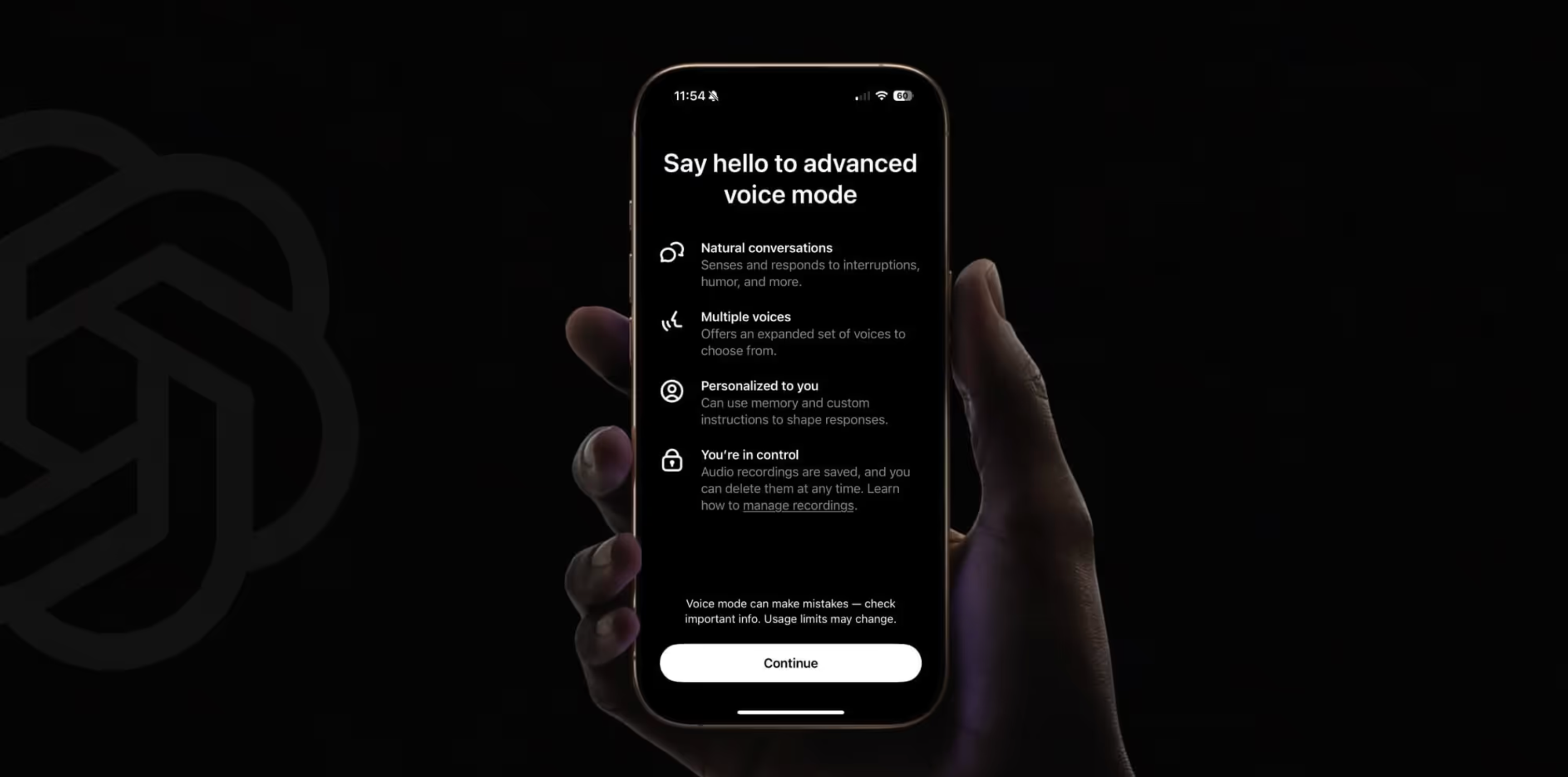

“o” 代表“omni”,暗示该模型可以处理语音、文本和视频。语音是 GPT-4o 和其支持的流行聊天机器人ChatGPT的一大亮点。ChatGPT 以前通过文本转语音支持语音交互,现在它更接近真正的人类助手,具有检测用户情绪并以自己的情绪做出回应等功能。它甚至可以唱歌。

除此之外,GPT-4o 的视觉能力也得到了提升,例如能够通过分析照片来识别衣服,或者通过分析桌面屏幕来分析软件代码。

在各种新的视频演示中,GPT-4o 用户展示了不同的功能,例如辅导学生数学、赞美老爸笑话、为视力受损的用户提供指导,甚至与自己的其他版本(GPT-4o 对 GPT-4o)聊天。与其他一些 OpenAI 公告不同,GPT-4o 目前在 ChatGPT 的免费层中提供,因为 OpenAI 公告对新技术的访问极为有限。