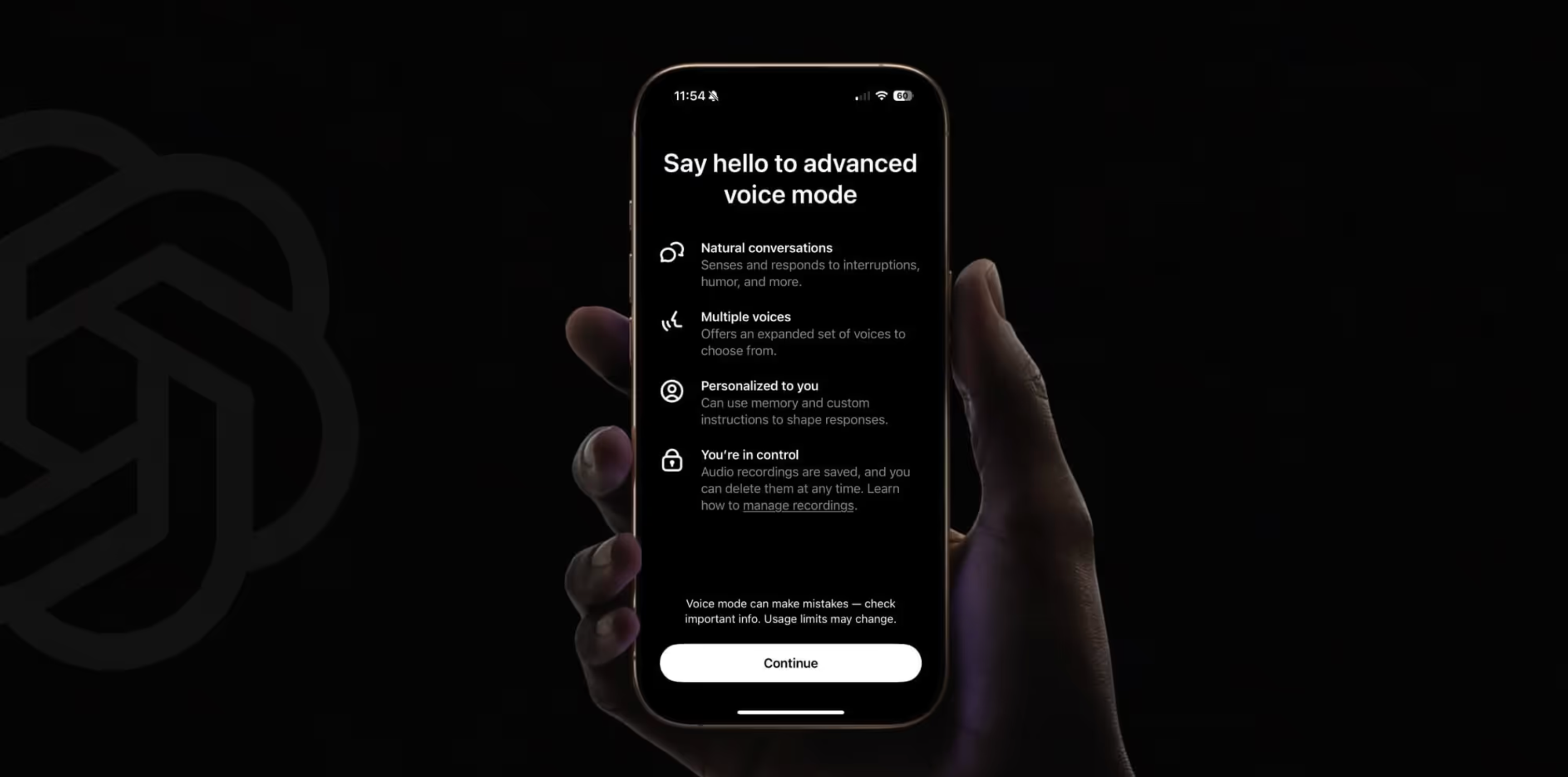

ChatGPT的伦理挑战:责任与透明度

为了让大家能够体验上ChatGPT4.0,小编找了能用GPT-4的网站,亲测好用!

www.chatgp1.com

ChatGPT的伦理挑战主要集中在责任与透明度两个方面。以下是对这两个方面的详细探讨:

一、责任挑战

- 数据权益侵犯

- ChatGPT在训练和使用过程中涉及大量数据,这些数据可能包含个人隐私和敏感信息。如果数据保护措施不到位,可能导致数据泄露和滥用,从而侵犯用户的隐私权和数据权益。

- 学术伦理挑战

- ChatGPT的强大创作能力使得学术作弊变得更加容易。例如,学生可以使用ChatGPT快速生成论文或作业,绕过查重系统,对学术诚信构成严重威胁。

- 学术界对于ChatGPT生成的文本是否应被视为原创作品存在争议。一些学术期刊和出版商已经开始限制或禁止ChatGPT生成的内容,以避免学术伦理问题。

- 知识信任危机

- ChatGPT生成的文本可能包含错误或误导性的信息,这可能导致读者对知识的信任度降低。

- ChatGPT的智能化程度有限,其生成的内容可能无法完全反映人类智慧和经验,从而引发知识信任危机。

- 社会公平问题

- ChatGPT等生成式人工智能的崛起可能加剧社会不平等。例如,与人工智能开发相关的职业可能拥有更高薪资,而被人工智能代替的职业可能面临降薪或失业的风险。

- ChatGPT的广泛应用可能导致“数字鸿沟”进一步扩大,使得部分人群无法跟上快速发展的社会智能化步伐。

二、透明度挑战

- 算法偏见与歧视

- ChatGPT的算法可能受到训练数据的影响,从而产生偏见和歧视。例如,如果训练数据中包含歧视性言论或刻板印象,ChatGPT在生成文本时可能无意中强化这些偏见。

- ChatGPT在面对复杂问题或情境时可能难以难以了解其给出生成正确的答案或建议,这可能导致误解或歧视性言论内容的的传播。

- 缺乏透明度

- ChatGPT的运作机制和算法细节通常不公开,这使得用户背后逻辑和依据。

- 缺乏透明度可能导致用户对ChatGPT的信任度降低,并引发对人工智能技术的质疑和担忧。

三、应对策略

为了应对ChatGPT带来的伦理挑战,需要采取以下策略:

- 加强数据隐私保护

- 采取严格的数据隐私保护措施,确保用户的数据安全和隐私不被泄露。

- 在数据收集、存储、传输等环节加强安全措施,采用加密技术等手段保护用户数据。

- 建立学术伦理规范

- 明确ChatGPT在学术领域的使用规范和限制,防止学术作弊和伦理问题。

- 学术期刊和出版商应加强对ChatGPT生成内容的审核和监管。

- 提高知识信任度

- 加强ChatGPT的算法优化和训练,提高其生成内容的准确性和可靠性。

- 引入第三方机构对ChatGPT生成的内容进行验证和评估。

- 推动社会公平与包容性

- 关注ChatGPT对劳动力市场和社会公平的影响,采取措施缓解不平等现象。

- 加强教育和培训,帮助被人工智能代替的职业人员转型和发展。

- 提高透明度

- 逐步公开ChatGPT的运作机制和算法细节,增加用户对其生成内容的了解和信任。

- 建立用户反馈机制,及时回应和解决用户关切的问题和疑虑。

综上所述,ChatGPT在带来便利和效率的同时,也带来了伦理挑战。为了充分发挥其积极作用并减少负面影响,需要政府、企业、学术界和社会各界共同努力,加强监管和自律,推动人工智能技术的健康、可持续发展。