ChatGPT表现不佳的原因及修复方法

随着人工智能技术的飞速发展,自然语言处理(NLP)领域也迎来了许多引人注目的突破。然而,尽管OpenAI的ChatGPT在多项任务中表现出色,但近期其性能却出现了波动,引发了广泛关注和讨论。本文将探讨ChatGPT表现不佳的原因,并提出相应的修复方法。

首先,我们需要了解ChatGPT表现不佳可能受到多种因素的影响。一方面,训练数据的多样性和质量直接影响模型的表现。如果训练数据过于单一或存在偏见,可能会导致模型对特定类型的输入产生偏差,从而影响其泛化能力。另一方面,模型架构的选择也是影响性能的关键因素。不同的模型架构适用于不同类型的问题和任务,如果选择不当,可能会导致模型在某些场景下表现不佳。此外,算法优化和参数调整也是提升模型性能的重要手段。通过不断优化算法和调整参数,可以使得模型更加高效地学习和适应新的问题。

针对上述原因,我们可以从以下几个方面进行修复:

- 丰富和多样化的训练数据。为了提高模型的泛化能力,需要收集更多种类的数据,包括不同领域、不同风格和不同语境的数据。同时,还可以引入外部数据集,以增加数据的多样性。此外,还可以采用数据增强技术,如图像旋转、缩放、翻转等,来丰富数据的特征。

- 选择合适的模型架构。根据具体的应用场景和需求,选择适合的模型架构。例如,对于文本分类任务,可以选择BERT或Transformer架构;对于问答系统,可以选择BERT或RoBERTa等预训练模型。在选择模型架构时,还应考虑模型的性能、计算资源和训练时间等因素。

- 优化算法和参数。通过对模型结构进行调整,如增加注意力机制、引入多头输出等,可以提升模型的性能。同时,还可以使用正则化技术、dropout等方法来防止过拟合现象。此外,还可以尝试使用迁移学习、微调等策略,以利用已有的预训练模型并提升性能。

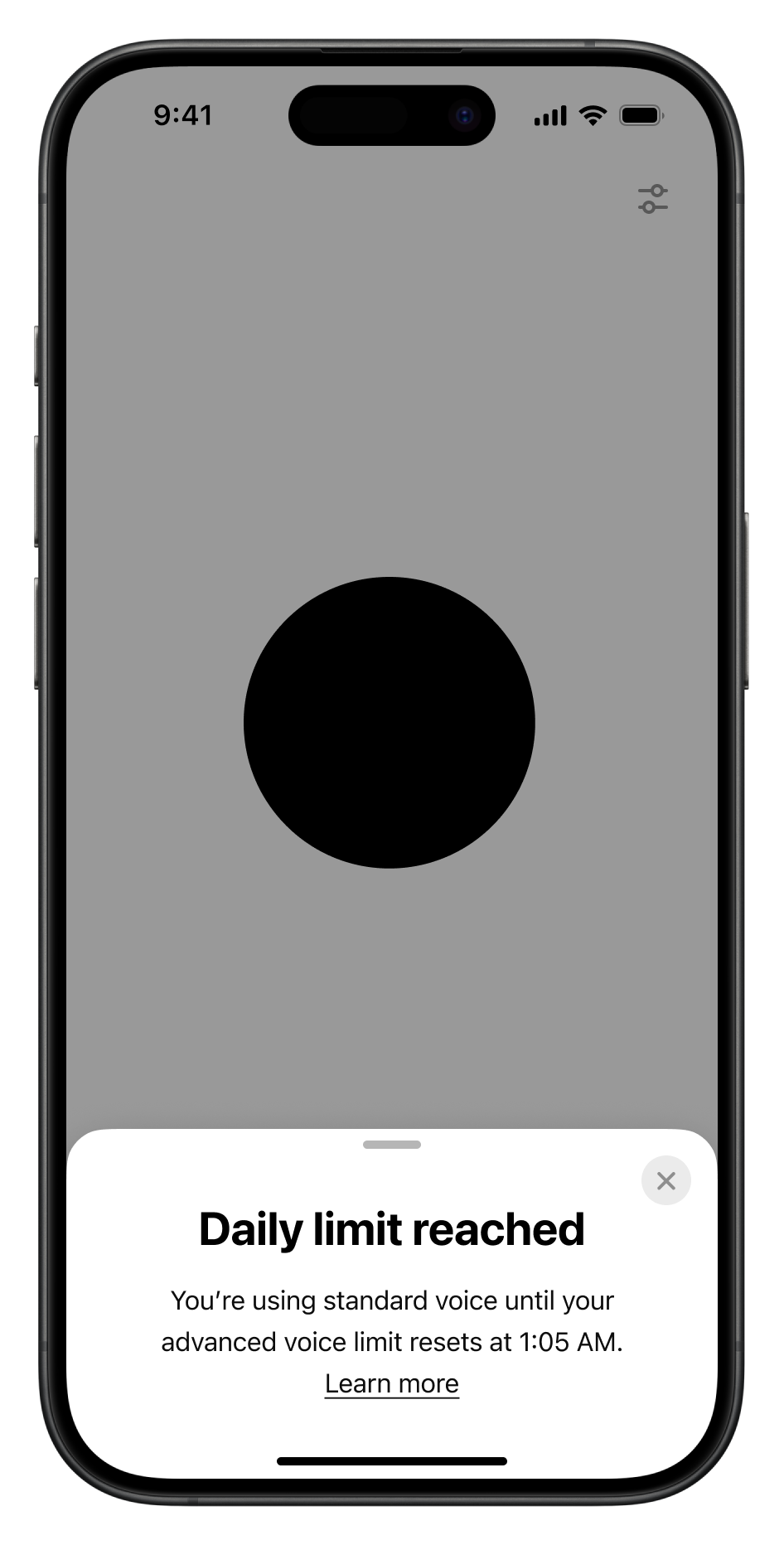

- 定期更新和迭代。随着技术的发展和数据的变化,模型可能需要进行更新和迭代。通过定期评估模型的性能,并根据评估结果对模型进行调整和优化,可以确保模型始终处于最佳状态。

ChatGPT表现不佳的原因主要在于训练数据的多样性和质量、模型架构的选择以及算法和参数的优化等方面。为了修复这些问题,我们需要采取一系列措施,如丰富和多样化训练数据、选择合适的模型架构、优化算法和参数以及定期更新和迭代等。通过这些努力,我们可以期待ChatGPT在未来能够展现出更加出色的性能。